Computational Human Dynamics (CHD)

Computational Human Dynamics (CHD) – Multimodal Social Signal Processing of Dyadic and Group Interactions

Mit der neuen Projektförderung im Rahmen der DFG-Exzellenzstrategie für ein Cross-Disciplinary Lab im House of Computing and Data Science legen Nale Lehmann-Willenbrock, Timo Gerkmann und Frank Steinicke die Grundlage für weitere interdisziplinäre Forschung. Die beiden Projekte werden zum einen die automatische Erkennung von Gruppenaffekt auf der Basis multimodaler Signale und zum anderen die Entwicklung von Interaktionsmustern und sozialen Dynamiken im Metaverse weiter erforschen. Dieses Forschungsprogramm ermöglicht die Beantwortung von wissenschaftlichen Fragestellungen aus Sicht der Informatik sowie der Arbeits- und Organisationspsychologie, die mit bestehenden Forschungsmethoden nicht bearbeitet werden können.

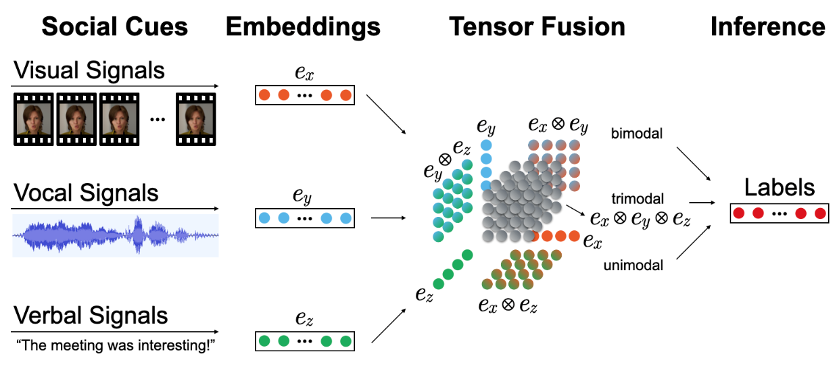

Project 1: Multimodal and Multilevel Modeling of Affect in Virtual Team Meetings

Virtuelle Meetings sind anfällig für zahlreiche Interaktionsprobleme, wie z. B. die starke Reduzierung nonverbaler Hinweise und die Beeinträchtigung der Wahrnehmung von Gefühlen. Die Bedeutung der Darstellung nonverbaler Hinweise und des Affekts für das Verständnis des Verhaltens von Mitarbeitenden, des Wohlbefindens und für das Funktionieren der Organisation im Allgemeinen ist tiefgreifend. Im Hinblick auf frühere Theorien zum Affekt in Team-Meetings als mehrstufiges und multimodales Konstrukt werden wir in diesem Projekt multimodale maschinelle Lernansätze verwenden, die Modalitäten wie Audio, Video und Semantik kombinieren, um den Affekt auf mehreren Interaktionsebenen zu modellieren, d. h. auf der Ebene des Einzelnen, der Dyade und der Gruppe.

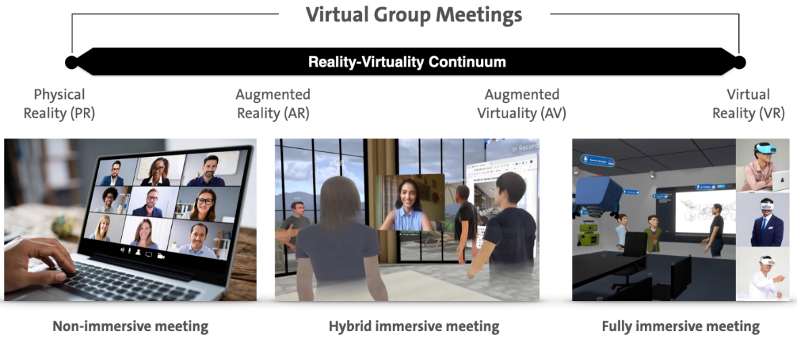

Project 2: Multimodal Social Signal Processing of Dyadic and Group Interactions in the Metaverse

Immersive Gruppentreffen im Metaverse bieten einen reichhaltigen Kontext für das Erkennen, Analysieren und Verstehen multimodaler Verhaltensmuster. Im Rahmen des unseres Projekts werden wir bestehende Methoden und Werkzeuge zur Verarbeitung sozialer Signale in Face-to-Face-Situationen (F2F) auf ihre Leistungsfähigkeit und Angemessenheit für immersive virtuelle Gruppentreffen analysieren und bewerten. Darüber hinaus werden wir diese Werkzeuge anpassen, neuartige KI-basierte Algorithmen entwickeln und sie in ein multimodales soziales Signalverarbeitungs-Modell zur Analyse, Verarbeitung und Annotation verschiedener Formen von (nicht-) immersiven virtuellen Gruppenmeetings integrieren. Dieses Rahmenmodell wird die technologische Basis für die Untersuchung dyadischer und gruppenbezogener Verhaltensprozesse sowie der damit verbundenen Dynamiken bilden.

Mitarbeitende:

Navin Laxminarayanan Raj Prabhu, Fachbereich Informatik, Signal Processing, Universität Hamburg

Marvin Grabowski, Fachbereich Arbeits- und Organisationspsychologie, Universität Hamburg

Sebastian Rings, Fachbereich Informatik, Universität Hamburg

Leitung:

Nale Lehmann-Willenbrock, Universität Hamburg, Fachbereich Arbeits- und Organisationspsychologie

Timo Gerkmann, Universität Hamburg, Fachbereich Informatik, Signal Processing

Frank Steinicke, Universität Hamburg, Fachbereich Informatik, Human-Computer Interaction